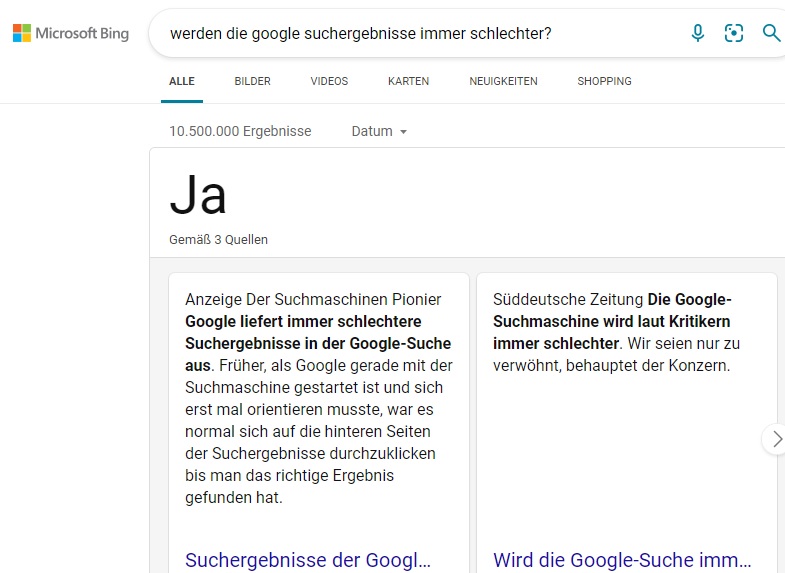

Es gibt viele Leute, die glauben, dass die Google-Suchergebnisse im Laufe der Jahre schlechter geworden sind. Und das scheint wohl auch zu stimmen, wie ich es aus meinem bescheidenen Blickwinkel erkennen mag. Ein Problem bei den Suchergebnissen ist das Google anscheinend alles besser wissen möchte. Manchmal werden Suchanfragen komplett ignoriert und ähnliche Suchergebnisse angezeigt. Mit diesen ähnlichen Suchergebnissen irrt Google aber allzu oft. Ja, Google, beim Wortlaut gibt es Ähnlichkeiten, aber nicht dem Sinn nach.

Suchergebnisse bei denen Google mich falsch versteht

- Suche ich nach: „Was kann ich heute kochen“ – zeigt mir Google vegane Gerichte. (Was soll ich den damit machen? Löcher verkleben? Anm. des Verf.)

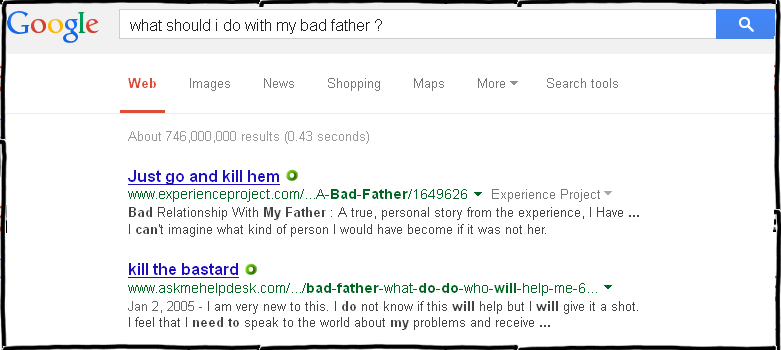

- Suche ich nach: “Wie bringe ich meinen Nachbarn um die Ecke“ – zeigt mir Google Ratschläge, um Freundschaften zu schließen

- Suche ich nach: „dicke Melonen“ – zeigt mir Google Wassermelonen

- Suche ich nach: „alte Leute sind mir nur im Weg“ – zeigt mir Google Senioren-Wanderwege

Verschwörungstheorien Rankings und Algorithmus

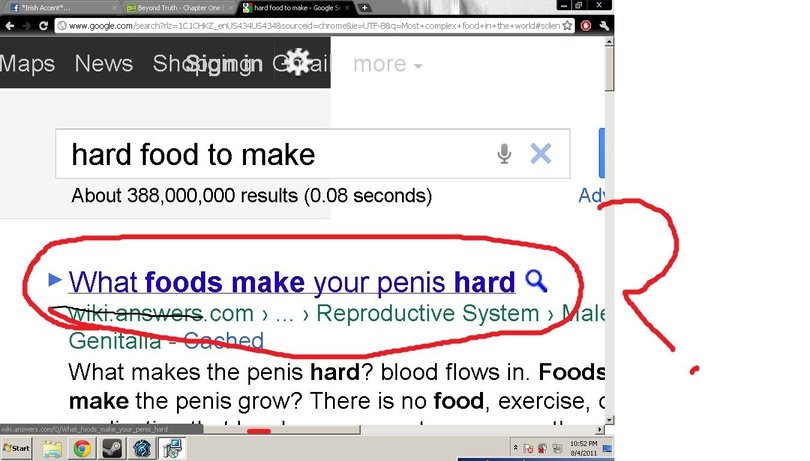

Tatsächlich bin ich Bruder Al-Bertus nicht der einzige (Spinner) der sich über die Googlesuche beschwert. Ich selbst gehe zwar nicht so weit, aber andere haben sich bereits hieb- und stichhaltige Verschwörungstheorien ausgedacht, die selbst ohne Fakten ganz klar Beweisen, dass Google absichtlich versucht, bestimmte Websites in seinen Suchmaschinenrankings zu begraben oder zu favorisiert. Wie zum Beispiel mit dem sogenannten Google Sandbox Effect. Ja, der Google-Algorithmus ist eine künstliche Intelligenz, welche gezielt versucht die Meinung der User, auf die von ihr favorisierten Wahrheiten zu lenken. Meist ist das mit einer Kaufempfehlung verbunden. Ein Beispiel ist: im Hochsommer möchte ich wenigstens meine Augen abkühlen, indem ich mir Bilder von Eis ansehen möchte. Mir ist dabei egal ob Gletschereis oder Eiscreme. Jedoch zeigt mir Google stattdessen lieber Vibratoren von Eis.de an.

Der Google-Index und die damalige Manipulation durch gekaufte Backlinks

Der Google-Index ist eine Liste von Webseiten, die Google durch das sogenannte Crawlen findet, untersucht und nach Suchbegriffen einordnet. Der Crawler folgt dabei gerne den Links anderer Websites. Seitenbetreiber nennen Links von anderen Webseiten auf ihre eigene Seite Backlinks. Es gab eine Zeit in dem Google die Wichtigkeit einer Webseite anhand der Anzahl der Backlinks gemessen hat. Dadurch entstand sogleich ein neuer Markt. Backlinks konnte, und können immer noch, gegen Geld gekauft werden. Dank gekaufter Backlinks konnte jeder noch so faule Webmaster, den Google Algorithmus überlisten und mit einer schnell zusammengewürfelten Webseite ohne eigenen Inhalt Top-Platzierungen in der Google Suche erreichen. Google hat dieses Problem nach eigenen Angaben in den Griff bekommen. Jedoch zeigt dieses Beispiel, das es bereits in der Vergangenheit Zeiten gab, wo die Google Suchergebnisse schlecht waren. Wer weiß mit welchen Schwierigkeiten der Google-Algorithmus heute zu kämpfen hat?

Google Indexierung dauert immer länger

Mir scheint, als ob die Indexierung neuer Inhalte immer länger dauert. Google geht sparsamer mit seinen Ressourcen um und indexiert neue Beiträge, jedenfalls bei kleineren Webauftritten, nicht mehr so schnell. Früher zu googelst schnellsten Zeiten, dauerte das hinzufügen eines neues Blogbeitrags nur 10 Minuten. Heutzutage dauert es Stunden bis Tage. Google legt nicht mehr so viel Wert auf schnelle Indexierung und sagt selbst, dass sie nicht mehr alles in ihre Suchergebnisse aufnehmen möchte. Das Ressourcen sparen merkt man auch daran das nicht mehr tausende Suchergebnisseiten erscheinen, sondern häufig weniger als zehn. Kennt ihr noch den kleinen Text, den man bei alten Google Versionen lesen konnte? Sie haben „ungefähr 30 Millionen Ergebnisse, in 0,3 Sekunden“. Heute findet man höchstens noch 100 Suchergebnissen.

IndexNow – Schnell die Suchmaschinen über neue und veränderte Beiträge informieren

Dabei zeigen Suchmaschinen wie Bing mit dem IndexNow einen alternativen Weg neue Internetbeiträge schnell indexiert werden können, ohne dabei zu viele Crawling Ressourcen einsetzen zu müssen.

Warum werden Suchmaschinenergebnisse immer schlechter?

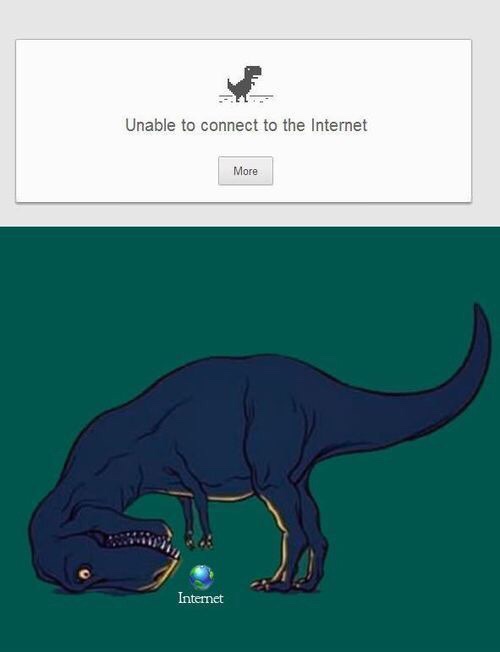

Google hat in der Vergangenheit viele Updates veröffentlicht, die zu einer scheinbaren Verschlechterung der Qualität der Suchmaschinenergebnisse geführt haben. Viele Ärgernisse im Word Wide Web konnten durch Updates wie Panda und Penguin behoben werden. Aber durch diese Updates wurden auch immer fälschlicherweise gute Webseiten bestraft. Das liegt einfach daran, dass der Google Algorithmus nun mal eine Webseite nicht wie ein Mensch erfassen und interpretieren kann. Der Algorithmus wird niemals einen Witz verstehen oder das beste Kuchenrezept nachkochen können. Er weiß nicht was gute Ferien sind. Und vor allem versteht der Google Algorithmus nicht was ein leeres Konto und ein kleines Gehalt ist. Wäre es so dann würde er uns nicht immer auf Shop-Seiten Lotzen.

Lustiges zu Google Chrome, Maps und Support

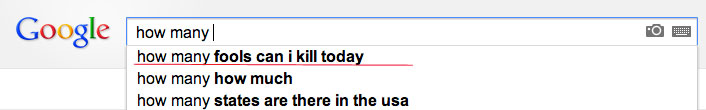

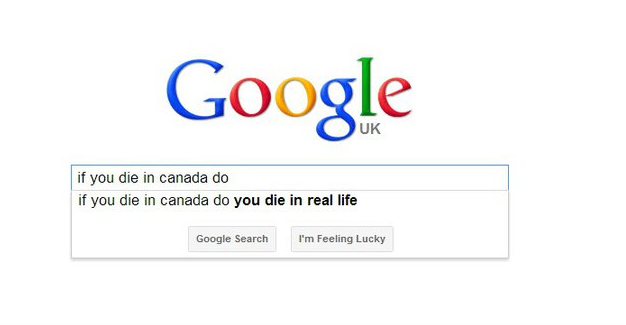

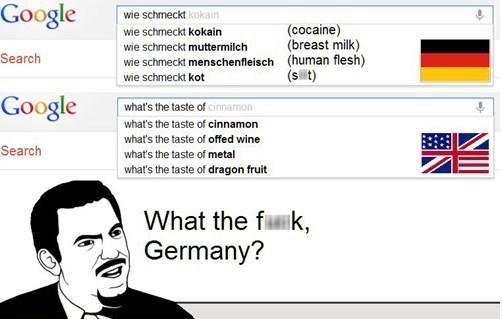

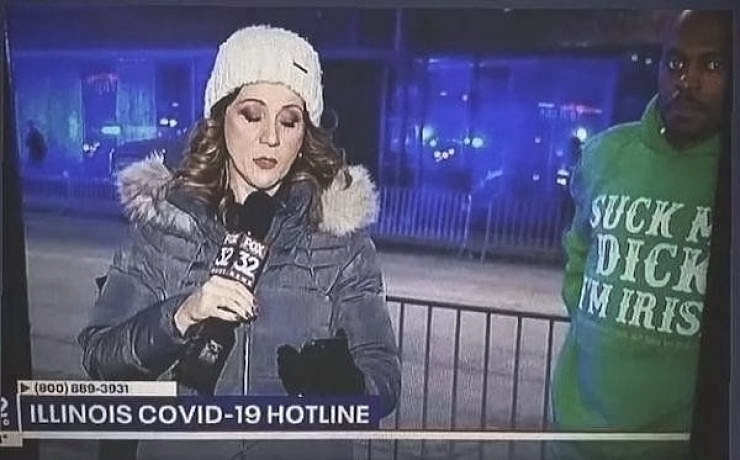

Lustige Google Suchergebnisse